题目:Learning Upright and Forward-Facing Object Poses using Category-level Canonical Representations

时间:2024年3月

期刊:2025 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

作者:西安交通大学博士生韩冰,王晨希副教授,赵志斌副教授等

简介:在机器人操作、三维感知与场景理解等任务中,如何对不同形状的物体建立统一的空间参考系(即canonical pose)始终是关键挑战。以往方法通常依赖人工对齐或明确的姿态标签,不仅耗费巨大,还难以适应真实环境中未经对齐的数据。为此,西安交通大学未来技术学院与机械工程学院的联合研究团队提出了一种无需姿态标签、适用于野外数据的三维物体标准姿态规范化方法,该方法使得各种野外数据对齐到一个具有实际物理意义(竖直+面向前方)的规范参考系。

项目网址:https://anon-mity.github.io/upright-facing/

摘要:为3D物体类别构建统一的规范姿态表示对于姿态估计和机器人场景理解至关重要。以往的统一姿态表示通常依赖手动对齐,例如在ShapeNet和ModelNet中。近年来,自监督规范化方法被提出,然而,它们对类内形状变化敏感,且其规范姿态表示无法与以物体为中心的坐标系对齐。在本文中,我们提出一种类别级规范化方法,该方法减轻形状变化的影响,并将规范姿态表示扩展到直立且面向前方的状态。首先,我们设计了孪生VN模块(SVNM),实现了SE (3)等变建模以及3D形状和姿态属性的自监督解耦。其次,我们引入孪生等变约束,以解决由形状变形引起的姿态对齐偏差。最后,我们提出一种从姿态未知的野外数据中生成直立表面标签的方法,并利用直立损失和对称损失来校正规范姿态。实验结果表明,我们的方法不仅达到了最先进的一致性性能,还能与以物体为中心的坐标系对齐。

关键词:点云规范化,SE(3)等变表示,场景理解,位姿估计,物体摆放。

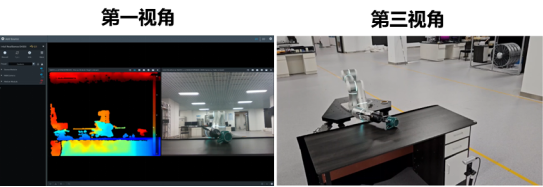

图1 我们提出了一种类别级点云规范化方法,该方法在同一类别内的不同实例之间学习统一的规范化姿态。我们进一步扩展这个规范的姿势,以保持直立和向前的状态。我们的方法消除了手工制作物体姿态标签的需要,并有效地处理形状变化。

一、方法

第一步:学习无偏好的规范表示,解耦形状与姿态属性

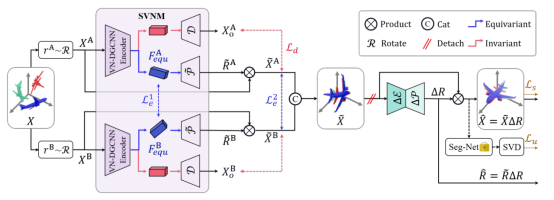

我们首先设计了孪生向量神经元模块(SVNM),基于向量神经元网络(VNN)构建SE (3)等变模型,实现3D形状与姿态属性的自监督解耦。具体而言,通过对输入点云进行中心预处理(将质心移至原点),使模型具备平移等变性;再利用共享参数的孪生网络,对同一形状的随机旋转副本进行处理,通过等变约束确保特征变换与输入旋转一致,避免因类内形状差异导致的姿态对齐偏差。我们将规范表示使用SO(3)不变表示解码得到,这一步能将不同姿态的同类物体点云转化为统一的无偏好规范表示。

图2:方法整体架构

第二步:将无偏好的规范表示对齐到直立且正向的状态

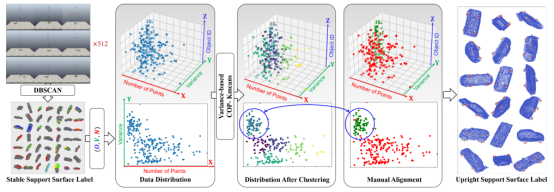

我们提出从无姿态标注的野外数据中自动生成直立表面标签。首先在CoppeliaSim中模拟物体自由下落运动:将物体随机旋转为512种姿态并从高处释放,跟踪其稳定静止后的姿态,通过DBSCAN算法聚类出所有可能的支撑面;随后利用基于方差的约束Kmeans算法,从这些支撑面中筛选出直立支撑面(如汽车的底面、椅子的椅面)。接着,使用PointM2AE作为分割网络识别规范表示的直立支撑面,计算其法向量与+ Z方向的角度差作为直立损失,驱动网络学习残差旋转,最终使物体直立方向与+ Z轴对齐。针对面向前方方向的对齐,我们利用对称性特征(如飞机的左右对称、汽车的侧向对称),定义对称面,通过计算规范表示与其在对称平面镜像的倒角距离作为对称损失,约束物体前方方向与+ X轴对齐。这一步与直立损失协同作用,使网络学习的残差旋转同时满足直立和面向前方的双重约束。

图3 直立表面标签生成。我们的方法可有效对支撑面进行聚类,甚至能接近手动对齐的数据效果。

二、实验

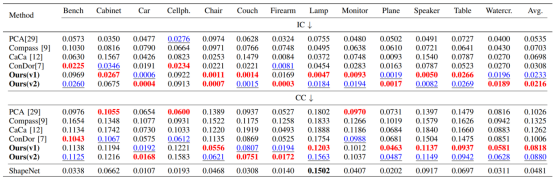

我们对比了六个经典的规范化方法,PCA, Compass (NIPS2020), CaCa(NIPS2021),ConDor(CVPR2022), VN-SPD(ECCV2022) and CHOIR(ICML2023)。我们的方法在大部分类别上取得取得最先进的性能。

表1 在实例一致性(IC)和类别一致性(CC)指标的对比中,我们的方法在大多数类别中展现出最先进(SOTA)的性能。

红色粗体值表示最佳性能,蓝色下划线值表示次优性能。

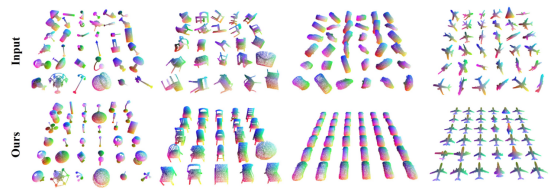

除此之外,我们的方法能够将野外点云转化为与欧几里得坐标系同步的对齐数据(如飞机驾驶舱始终对齐+ Y轴,汽车车轮始终接触Z=0平面),而无需任务手动姿态标注。为机器人抓取、环境理解等任务提供了更具物理意义的规范参考系。

图4 定性结果

三、下游任务

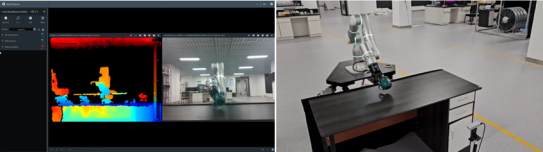

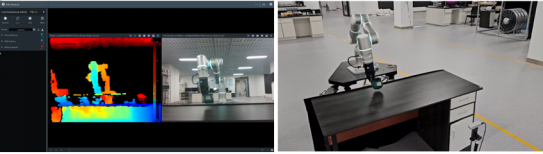

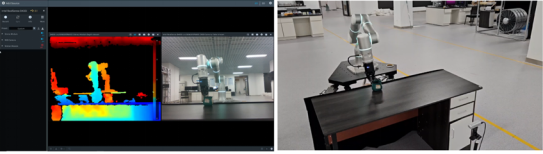

我们还进行了真实世界的实验来评估我们的方法驱动物体放置任务的性能。尽管我们的方法纯粹在仿真数据中进行训练,但在现实场景中对未见目标有效执行。我们使用Flexiv RIZON 4S机械臂和RealSence 435D RGB-D相机进行了实验。其中,RealSence 435D放置在桌子侧面,用来模拟人类的视线。在图像的前处理中,我们借用SAM2来分割目标对象和抓手。我们从RGB图像中分割目标对象的可见区域,并使用掩码裁剪深度图像。然后,我们从深度图像中采样点云,并将其馈送到我们的papeline中。我们的方法预测了最稳定的平面和相应的位姿,计算了平面与桌子之间的旋转值。然后,我们使用Flexiv RIZON 4S默认的机器人规划算法将目标对象放在桌子上。

图5 在机器人放置的下游任务上的结果

【作者简介】

韩冰(第一作者),西安交通大学未来技术学院博士在读,主要研究方向为:位姿估计,SO(3)等变表示与具身智能。

潘锐滔,西安交通大学未来技术学院博士在读,主要研究方向为:SLAM,航天器目标检测,事件传感。

张馨雨,西安交通大学未来技术学院硕士在读,主要研究方向为:非合作目标感知。

王晨希,西安交通大学机械工程学院副教授,主要研究方向为:故障诊断,自适应控制与强化学习。

赵志斌,西安交通大学机械工程学院副教授(通讯作者),主要研究方向为:多模态环境感知,大数据驱动的健康状态监测等。

翟智,西安交通大学机械工程学院研究员。主要研究方向为:航天器智能制造与健康管理。

陈雪峰,西安交通大学机械工程学院教授。国家杰出青年,973首席科学家。主要研究方向为:高端装备智能运维。